HDFS基本操作

启动HDFS的守护进程

start-dfs.sh

1、导入文件

准备一些测试文件

[hadoop@wxjtest195 ~]$ mkdir sample_data [hadoop@wxjtest195 ~]$ cp /opt/hadoop-2.6.1/etc/hadoop/* sample_data/

导入文件示例:

[hadoop@wxjtest195 ~]$ hdfs dfs -put sample_data/hadoop-policy.xml /policy.xml

/policy.xml代表存放到hdfs的根目录中

导入多个文件示例:

[hadoop@wxjtest195 ~]$ hdfs dfs -put sample_data/httpfs-env.sh sample_data/mapred-env.sh /user/hadoop

最后都是以HDFS的路径结尾就可以了

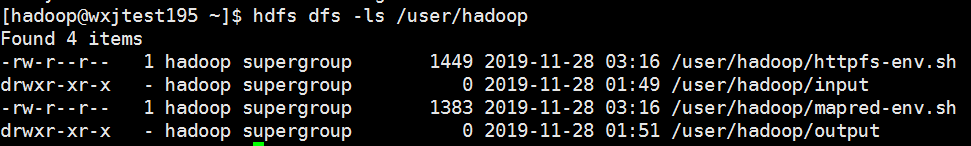

查看HDFS目录中的文件

2、查看HDFS文件内容

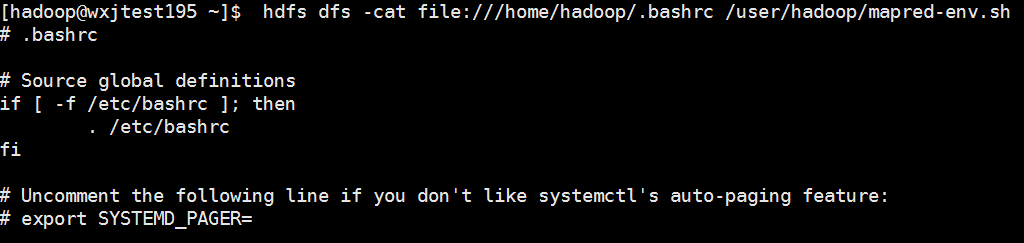

查看HDFS文件的内容则使用cat参数,如果需要对比本地的文件,本地目录可以使用file://代表本地路径。

[hadoop@wxjtest195 ~]$ hdfs dfs -cat file:///home/hadoop/.bashrc /user/hadoop/mapred-env.sh

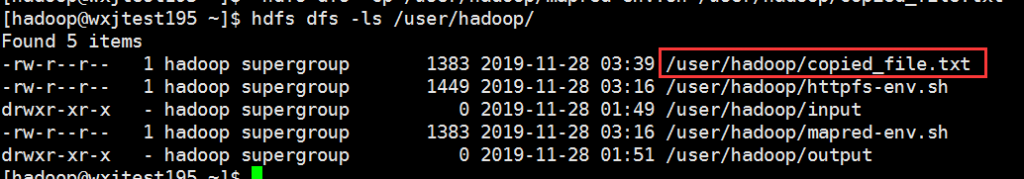

3、复制到HDFS文件系统

[hadoop@wxjtest195 ~]$ hdfs dfs -cp /user/hadoop/mapred-env.sh /user/hadoop/copied_file.txt

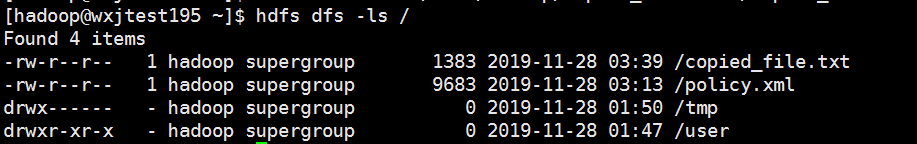

4、移动到HDFS文件系统

[hadoop@wxjtest195 ~]$ hdfs dfs -mv /user/hadoop/copied_file.txt /copied_file.txt

5、追加到HDFS文件系统的文件

使用 appendToFile 参数,最后一个参数为被追加的对象

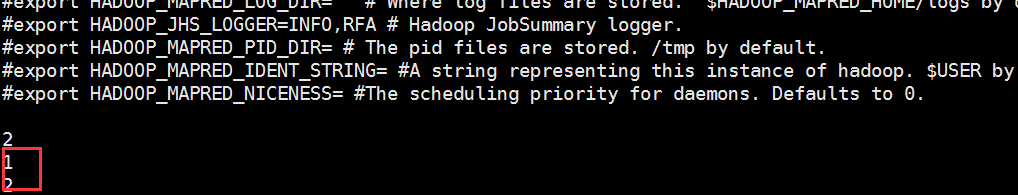

[hadoop@wxjtest195 ~]$ echo 1>a.txt [hadoop@wxjtest195 ~]$ echo 2>b.txt [hadoop@wxjtest195 ~]$ hdfs dfs -appendToFile a.txt b.txt /user/hadoop/mapred-env.sh

6、查看HDFS文件系统尾部内容

[hadoop@wxjtest195 ~]$ hdfs dfs -tail /user/hadoop/mapred-env.sh

7、删除文件系统的文件和目录

[hadoop@wxjtest195 ~]$ hdfs dfs -ls / Found 4 items -rw-r--r-- 1 hadoop supergroup 1383 2019-11-28 03:39 /copied_file.txt -rw-r--r-- 1 hadoop supergroup 9683 2019-11-28 03:13 /policy.xml drwx------ - hadoop supergroup 0 2019-11-28 01:50 /tmp drwxr-xr-x - hadoop supergroup 0 2019-11-28 01:47 /user [hadoop@wxjtest195 ~]$ hdfs dfs -rm /copied_file.txt 19/11/28 03:50:02 INFO fs.TrashPolicyDefault: Namenode trash configuration: Deletion interval = 0 minutes, Emptier interval = 0 minutes. Deleted /copied_file.txt [hadoop@wxjtest195 ~]$ hdfs dfs -ls / Found 3 items -rw-r--r-- 1 hadoop supergroup 9683 2019-11-28 03:13 /policy.xml drwx------ - hadoop supergroup 0 2019-11-28 01:50 /tmp drwxr-xr-x - hadoop supergroup 0 2019-11-28 01:47 /user

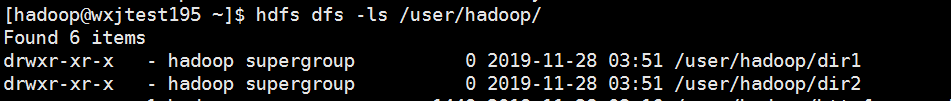

8、创建目录

[hadoop@wxjtest195 ~]$ hdfs dfs -mkdir -p /user/hadoop/dir1 /user/hadoop/dir2

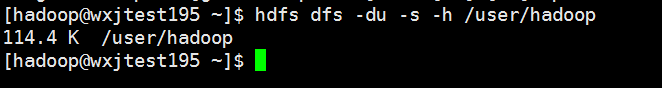

9、查看空间占用

10、导出文件

[hadoop@wxjtest195 ~]$ hdfs dfs -get /user/hadoop/mapred-env.sh exported_file.txt

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。