ChatGPT-on-WeChat 部署教程:打造你的专属 AI 助手

📌 项目简介

ChatGPT-on-WeChat(又名 CowAgent)是一个基于大模型的超级 AI 助理开源项目,能够主动思考和任务规划、访问操作系统和外部资源、创造和执行 Skills、拥有长期记忆。支持接入飞书、钉钉、企业微信、微信公众号、网页等多种渠道,可选择 OpenAI/Claude/Gemini/DeepSeek/Qwen/GLM/Kimi 等主流大模型。

GitHub 地址:https://github.com/zhayujie/chatgpt-on-wechat

🌟 核心功能

- 复杂任务规划:能够理解复杂任务并自主规划执行,持续思考和调用工具直到完成目标

- 长期记忆:自动将对话记忆持久化至本地文件和数据库中,支持关键词及向量检索

- 技能系统:内置多种技能,支持通过自然语言对话完成自定义 Skills 开发

- 多模态消息:支持文本、图片、语音、文件等多类型消息处理

- 多模型接入:支持 OpenAI、Claude、Gemini、DeepSeek、MiniMax、GLM、Qwen、Kimi 等

- 多端部署:可接入网页、飞书、钉钉、微信公众号、企业微信应用

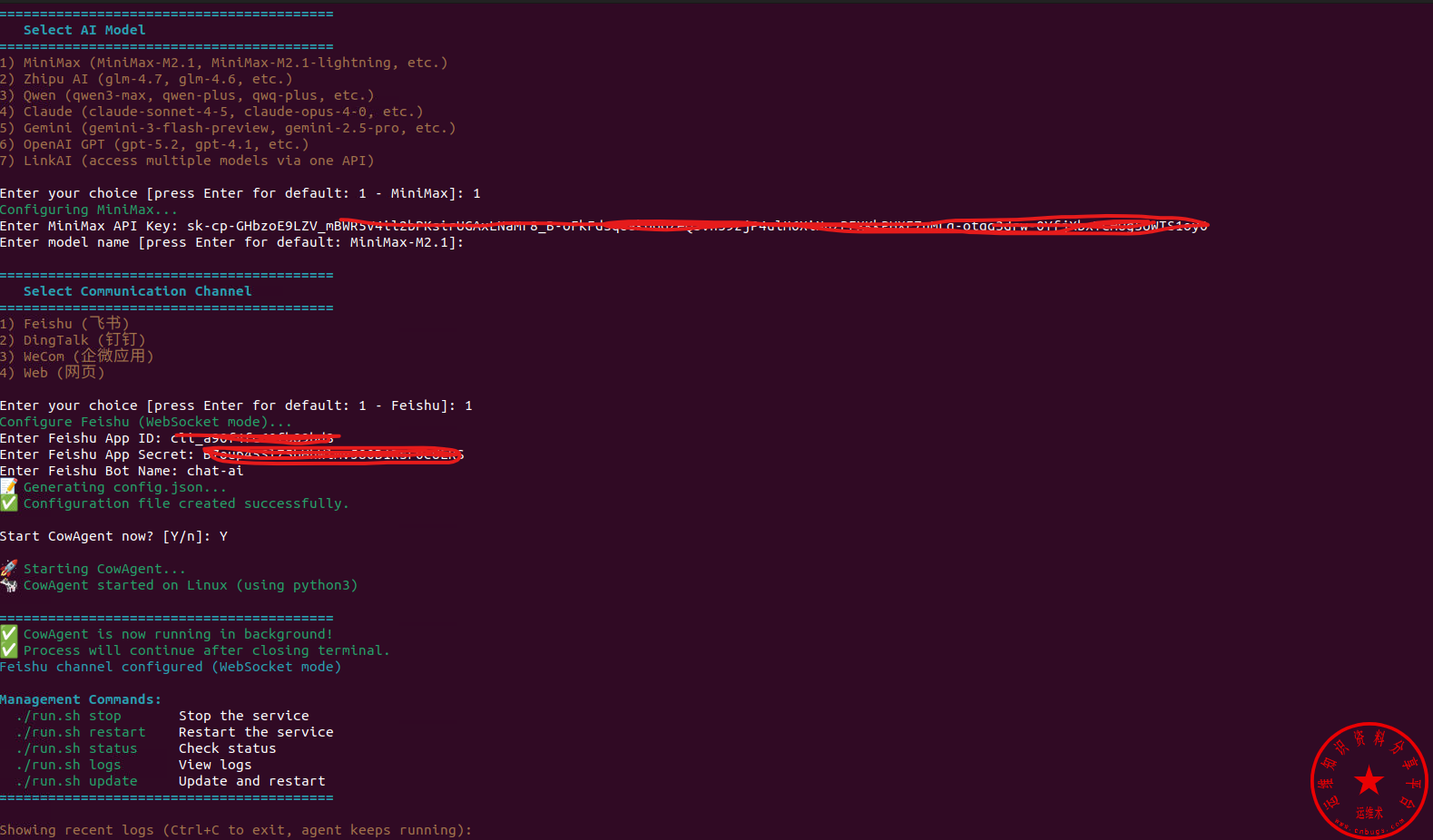

🚀 一键快速部署

项目提供了一键安装脚本,在终端执行以下命令即可:

bash <(curl -sS https://cdn.link-ai.tech/code/cow/run.sh)脚本会自动完成安装、配置、启动等操作,非常适合新手使用。

对接飞书应用机器人

飞书应用权限设置

{

"scopes": {

"tenant": [

"aily:message:read",

"aily:message:write",

"application:application.app_message_stats.overview:readonly",

"cardkit:card:write",

"im:app_feed_card:write",

"im:chat",

"im:chat.access_event.bot_p2p_chat:read",

"im:chat.members:read",

"im:chat:read",

"im:chat:readonly",

"im:chat:update",

"im:message",

"im:message.group_msg",

"im:message.p2p_msg:readonly",

"im:message.reactions:read",

"im:message.reactions:write_only",

"im:message:readonly",

"im:message:recall",

"im:message:send_as_bot",

"im:message:update",

"vc:meeting:readonly"

],

"user": [

"im:chat.access_event.bot_p2p_chat:read",

"im:message",

"im:message.pins:read",

"im:message.pins:write_only",

"im:message.reactions:read",

"im:message.reactions:write_only",

"im:message.urgent.status:write",

"im:message:readonly",

"im:message:recall",

"im:message:update"

]

}

}📦 手动部署教程

1. 环境要求

- 操作系统:Linux / MacOS / Windows

- Python 版本:3.7 ~ 3.12(推荐 3.9)

2. 克隆项目

# 从 GitHub 克隆

git clone https://github.com/zhayujie/chatgpt-on-wechat

cd chatgpt-on-wechat/

# 国内用户可使用 Gitee 镜像

git clone https://gitee.com/zhayujie/chatgpt-on-wechat

cd chatgpt-on-wechat/3. 安装依赖

# 安装核心依赖(必选)

pip3 install -r requirements.txt

# 安装扩展依赖(可选,建议安装)

pip3 install -r requirements-optional.txt4. 配置文件

复制配置模板并编辑:

cp config-template.json config.json编辑 config.json 文件,填入你的配置:

{

"channel_type": "web",

"model": "gpt-4o-mini",

"open_ai_api_key": "sk-xxxxxxxxxxxxxxxx",

"open_ai_api_base": "https://api.openai.com/v1",

"proxy": "",

"agent": true

}5. 启动运行

# 本地运行

python3 app.py

# Windows 用户

python app.py运行后访问 http://localhost:9899/chat 即可在网页端对话。

🐳 Docker 部署

使用 Docker 部署无需下载源码和安装依赖,更加简单。

1. 安装 Docker

确保已安装 Docker 和 Docker Compose:

# 检查是否安装

docker -v

docker compose version2. 下载配置文件

wget https://cdn.link-ai.tech/code/cow/docker-compose.yml编辑 docker-compose.yml,填入你的 API Key 等配置。

3. 启动容器

# 启动容器

sudo docker compose up -d

# 查看运行状态

sudo docker ps

# 查看日志

sudo docker logs -f chatgpt-on-wechat🔧 模型配置示例

OpenAI

{

"model": "gpt-4o-mini",

"open_ai_api_key": "sk-xxxxxxxx",

"open_ai_api_base": "https://api.openai.com/v1"

}DeepSeek

{

"model": "deepseek-chat",

"open_ai_api_key": "sk-xxxxxxxx",

"open_ai_api_base": "https://api.deepseek.com/v1",

"bot_type": "chatGPT"

}通义千问 (Qwen)

{

"model": "qwen-max",

"dashscope_api_key": "sk-xxxxxxxx"

}智谱 GLM

{

"model": "glm-4-flash",

"zhipu_ai_api_key": "xxxxxxxx"

}Claude

{

"model": "claude-3-5-sonnet-latest",

"claude_api_key": "sk-ant-xxxxxxxx"

}Gemini

{

"model": "gemini-2.0-flash",

"gemini_api_key": "xxxxxxxx"

}📱 接入渠道配置

修改 config.json 中的 channel_type 参数即可切换接入渠道:

web- 网页端(默认)terminal- 终端命令行feishu- 飞书dingtalk- 钉钉wechatcom_app- 企业微信应用wechatmp- 微信公众号(订阅号)wechatmp_service- 微信公众号(服务号)

🖥️ 服务器后台运行

# 后台运行

nohup python3 app.py & tail -f nohup.out

# 查看进程

ps -ef | grep app.py | grep -v grep

# 停止进程

kill

# 重新查看日志

tail -f nohup.out ⚠️ 注意事项

- Agent 模式:Token 消耗较高,请根据效果及成本综合选择模型

- 安全提醒:Agent 具有访问操作系统的能力,请谨慎选择部署环境

- 国内网络:使用 OpenAI/Claude 等国外模型需配置代理

- 推荐模型:Agent 模式推荐使用 MiniMax-M2.1、glm-4、qwen-max 等

🔗 相关链接

- GitHub:https://github.com/zhayujie/chatgpt-on-wechat

- Gitee 镜像:https://gitee.com/zhayujie/chatgpt-on-wechat

- 官方文档:https://github.com/zhayujie/chatgpt-on-wechat/wiki

- LinkAI 平台:https://link-ai.tech

💡 有问题欢迎在评论区留言讨论!

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。